昨日に引き続き、今日は大規模言語モデル(LLM)のファインチューニングに挑戦し始めました。目標は、特定のタスクやドメインに特化したLLMを構築し、その技術を深く理解することです。

ファインチューニングとは、既存のLLMに追加の学習を行い、特定の目的に適応させるプロセスです。例えば、専門的な用語を覚えさせたり、特定の会話スタイルを学習させたりすることができます。

なぜファインチューニングが必要になるのか?それは、汎用的なLLMが特定の分野では十分な性能を発揮できないことが多いからです。

例えば、医療や法律といった専門知識が求められる分野では、専門用語や業界特有の言い回しを理解させる必要があります。また、カスタマーサポートのように、特定の応答が求められる場合には、その応答を学習させる必要があります。

さて、意気揚々とファインチューニングを始めようとした私ですが、最初の壁にぶつかりました。それは、計算資源の問題です。ローカルマシンではGPUパワーが不足し、大規模なLLMを扱うことが難しかったのです。

そこで、Google Colabの利用を検討しました。しかし、ここでも新たな問題が発生しました。

LLMモデルを読み込むために、Hugging Face HubからダウンロードしたファイルをColabにアップロードする必要があったのですが、ファイルサイズが大きく、アップロードに時間がかかりすぎるのです。

途方に暮れていた時、Geminiに相談してみることを思いつきました。そしてGeminiから、Hugging Face Hubから直接モデルを読み込む方法を教えてもらうことができたのです。

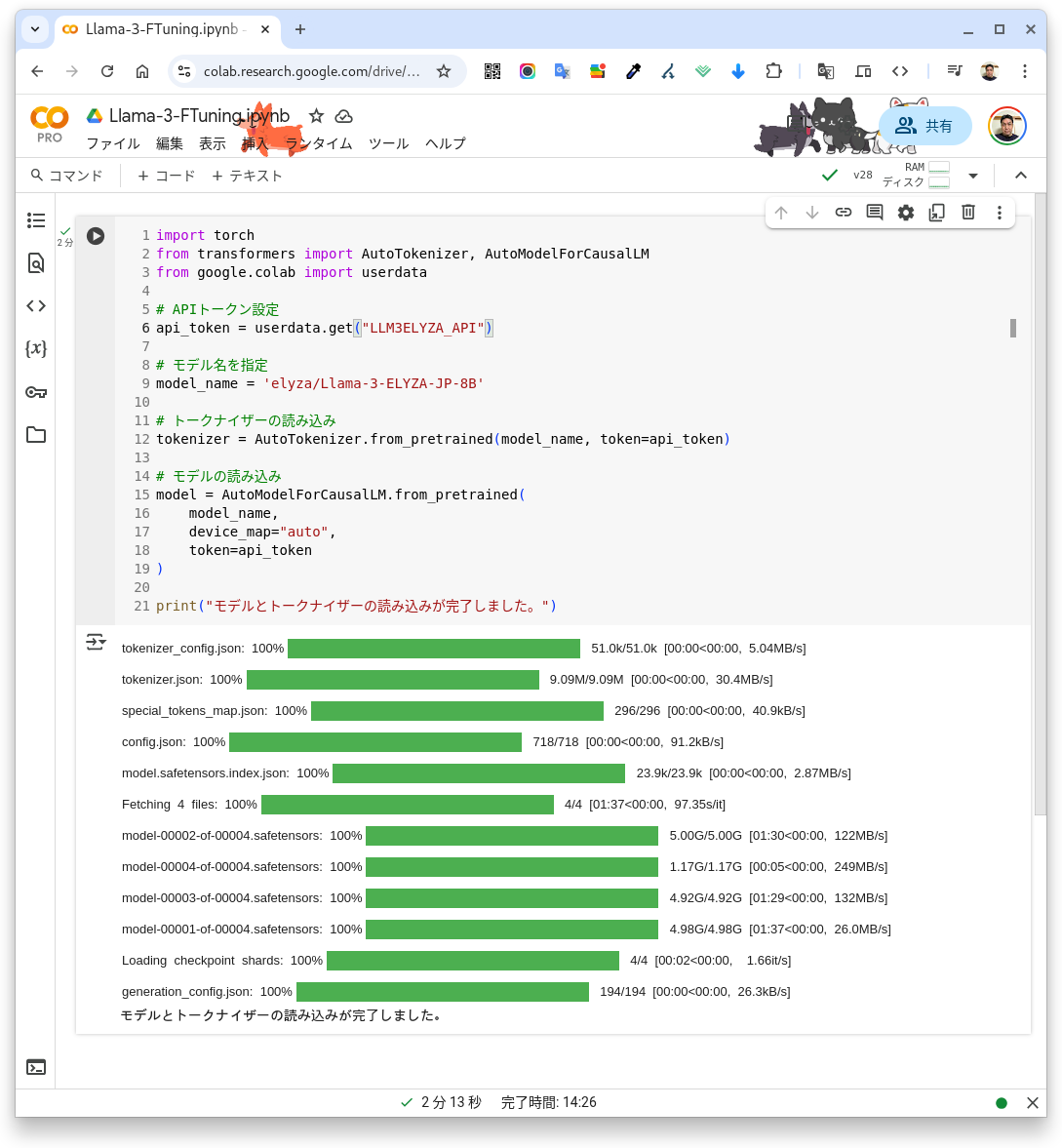

以下は、Geminiとのやり取りを通じて完成したコードです。

# Python Code

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

from google.colab import userdata

# APIトークン設定

api_token = userdata.get("secret_code")

#secret_code Hugging Face API のValueを環境変数にして設定しています。

# モデル名を指定

model_name = 'elyza/Llama-3-ELYZA-JP-8B'

# トークナイザーの読み込み

tokenizer = AutoTokenizer.from_pretrained(model_name, token=api_token)

# モデルの読み込み

model = AutoModelForCausalLM.from_pretrained(

model_name,

device_map="auto",

token=api_token

)

print("モデルとトークナイザーの読み込みが完了しました。")

このコードでは、Hugging Face Hubから直接モデルとトークナイザーをロードしています。

今回使用したLLMモデルは、elyza/Llama-3-ELYZA-JP-8B です。このモデルは、日本語に特化した高性能なLLMとして注目されており、ファインチューニングによってさらに多様なタスクに対応できる可能性を秘めています。

※昨日紹介した ChatBot で利用した elyza/Llama-3-ELYZA-JP-8B-GGUF は推論用のモデルでありファインチューニングには利用できません。

ここで、モデルとトークナイザーの役割について簡単に説明します。

- モデル: LLMの本体であり、テキストデータを理解し、生成する能力を持っています。

- トークナイザー: テキストデータをモデルが処理できる形式(トークン)に変換するためのツールです。

簡単にいうとモデルとトークナイザーの読み込みは、LLM を使用するための「土台」となる重要なステップです。この準備が整うことで、LLM の強力な自然言語処理能力を最大限に活用できるようになります。

今回の経験を通じて、私は多くのことを学びました。計算資源の重要性、クラウド環境の活用方法、そしてGeminiのような強力なツールの存在です。

最後に

今回の記事は、LLMファインチューニングへの挑戦の第一歩にすぎません。今後は今回の気づきをベースに、ファインチューニングの学習を継続していきたいと考えています。具体的には、学習用データセットの作成、実際のファインチューニング、そしてモデルの評価といったステップを一つずつ丁寧に学び、理解を深めていきます。

そして、この学びの過程をブログを通じて共有することで、同じようにLLMに関心を持つ方々の役に立てれば嬉しいです。

ピンバック: Google DriveでLLMモデルを保存・再利用!効率的なファインチューニング環境を構築 | MIYAKAWA AI

ピンバック: Google ColabでLLMファインチューニング【実践】:WordPressデータからブログAIアシスタント作成 | MIYAKAWA AI

ピンバック: LLMファインチューニングのためのColab環境構築と主要ライブラリ概 | MIYAKAWA AI